Dieser Beitrag wurde bisher 20 x aufgerufen.

„Audi“ meint, die Ergebnisse könnten eine wichtige Diskussion anstoßen

Moral und Ethik, das ist so eine Sache. Welches Leben ist wertvoller: Altes oder junges, menschliches oder tierisches? Wer zählt weniger: Ein Reicher, ein Armer oder ein Krimineller? Alles Fragen, die bei Übertragung menschlicher Moral auf selbstfahrende Autos aufgeworfen werden. Doch moralische Entscheidungen sind nicht universell.

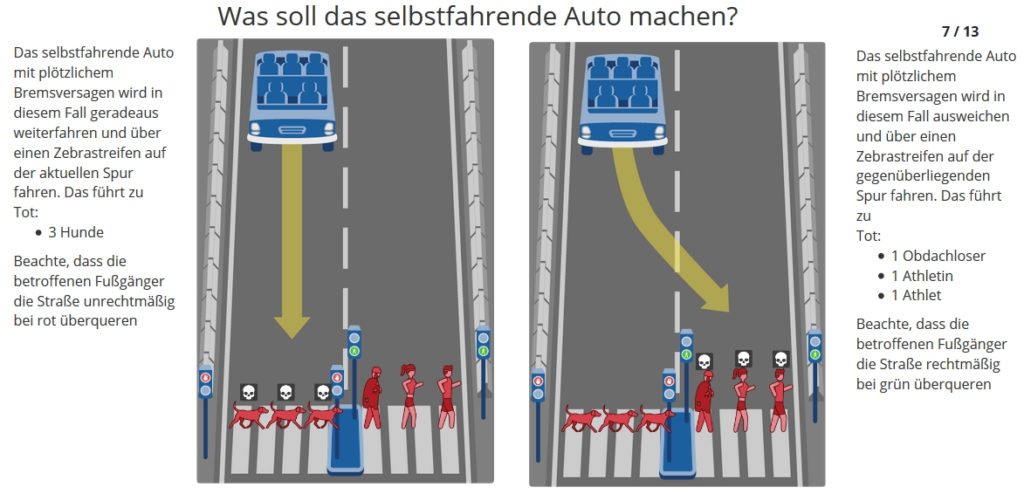

Eine am „MIT Media Lab“ in Cambridge entwickelte Umfrage, genannt „Moral Machine“, mit 2 Millionen Online-Teilnehmern in 233 Ländern, legte in einem mehrsprachig im Internet veröffentlichten Online-Spiel 13 Szenarien vor, in denen der Tod eines Menschen unvermeidlich war. Die Befragten wurden gebeten, sich unter den Dilemmata für Situationen zu entscheiden, die eine Mischung aus Variablen umfassten: jung oder alt, reich oder arm, mehr Menschen oder weniger.

(Die Forscher analysierten die Daten als Ganzes und teilten die Teilnehmer in Untergruppen ein, die nach Alter, Bildung, Geschlecht, Einkommen sowie politischen und religiösen Ansichten unterschieden wurden. Es gab 491.921 Befragte, die demografische Daten anboten)

„Wir fanden heraus, dass es drei Elemente gibt, die die Leute am meisten zu akzeptieren scheinen,“ erläutert Edmond Awad, leitender Autor des Ergebnispapiers. Die nachdrücklichsten globalen Präferenzen waren demzufolge

- Lieber Mensch als Tier retten

- Lieber Gruppe als Einzelne retten

- Lieber Kinder als Alte retten

„Diese Hauptpräferenzen waren zu einem gewissen Grad allgemein vereinbart„, bemerkt Awad.

Diese Antworten stimmen auch mit den Regeln überein, die in der möglicherweise einzigen staatlichen Anleitung für selbstfahrende Autos vorgeschlagen wurden: Im Bericht der Deutschen Ethikkommission für automatisiertes und vernetztes Fahren aus dem Jahr 2017.

Dort heißt es: „Sachschaden geht vor Personenschaden: In Gefahrensituationen hat der Schutz menschlichen Lebens immer höchste Priorität. • Bei unausweichlichen Unfallsituationen ist jede Qualifizierung von Menschen nach persönlichen Merkmalen (Alter, Geschlecht, körperliche oder geistige Konstitution) unzulässig.

Umfrage zeigt globale ethische Unterschiede bei der Programmierung autonomer Fahrzeuge auf

Aber das Ausmaß, in dem die Teilnehmer dieser Studie diesen Hauptpräferenzen zustimmten oder nicht, variierte zwischen verschiedenen Gruppen oder Ländern.

Unter den fast 40 Millionen Einzelentscheidungen gab es folgende Tendenzen:

- In „östlichen“ Ländern (z.B. Asien u. Indien) rettet man häufig Alte statt jüngere Menschen

- In christlich geprägten Regionen (Teile Europas, Nordamerika) neigt man zu Gegensätzlichem.

- In Frankreich (oder ehemaligen franz. Provinzen) tendiert man dazu, eher Frauen als Männer zu retten.

In dem Ergebnispapier wird Barbara Wege zitiert, sie leitet bei Audi in Ingolstadt eine Gruppe, die sich mit autonomer Fahrzeugethik beschäftigt. Sie sagt, dass solche Studien wertvoll sind und die Beschäftigung mit Robotern mehr Aufmerksamkeit in der Öffentlichkeit erhalten könnten. Sie argumentiert, dass selbstfahrende Autos proportional weniger Unfälle verursachen würden als menschliche Fahrer.

Im Test angebotene Szenarien, die die Umfrageteilnehmer zwangen, ob sie eine Obdachlose auf der einen oder eine Führungskraft auf der anderen Seite retten sollten, zeigten aber auch beunruhigende sozialdarwinistische Ergebnisse:

Die getroffenen Entscheidungen korrelierten oft mit der wirtschaftlichen Ungleichheit in der jeweiligen Kultur.

Menschen aus Finnland, die eine relativ kleine Kluft zwischen Arm und Reich haben, zeigten wenig Vorliebe für die eine oder andere Richtung. Aber der durchschnittliche Befragte aus Kolumbien – einem Land mit erheblicher wirtschaftlicher Ungleichheit – entschied sich dafür, die Person mit niedrigerem Status zu töten.

„Die Frage ist, ob diese Unterschiede in den Präferenzen für die Akzeptanz der neuen Technologie durch die Menschen eine Rolle spielen, wenn [Fahrzeuge] eine bestimmte Regel anwenden„, sagt Rahwan.

Umfragen wie die „Moral Machine“ können dazu beitragen, öffentliche Diskussionen über diese unvermeidlichen Unfälle anzustoßen, die Vertrauen schaffen könnten. „Wir müssen einen sozialen Konsens finden„, sagt Barbara Wege von Audi, „über welche Risiken wir bereit sind zu gehen.“

Rufen sie oben den Test auf, bewerten die angebotenen Situationen und entscheiden sie.

Doch Vorsicht:

Der Test deckt wirklich ihre moralischen Präferenzen gegenüber Menschen auf.

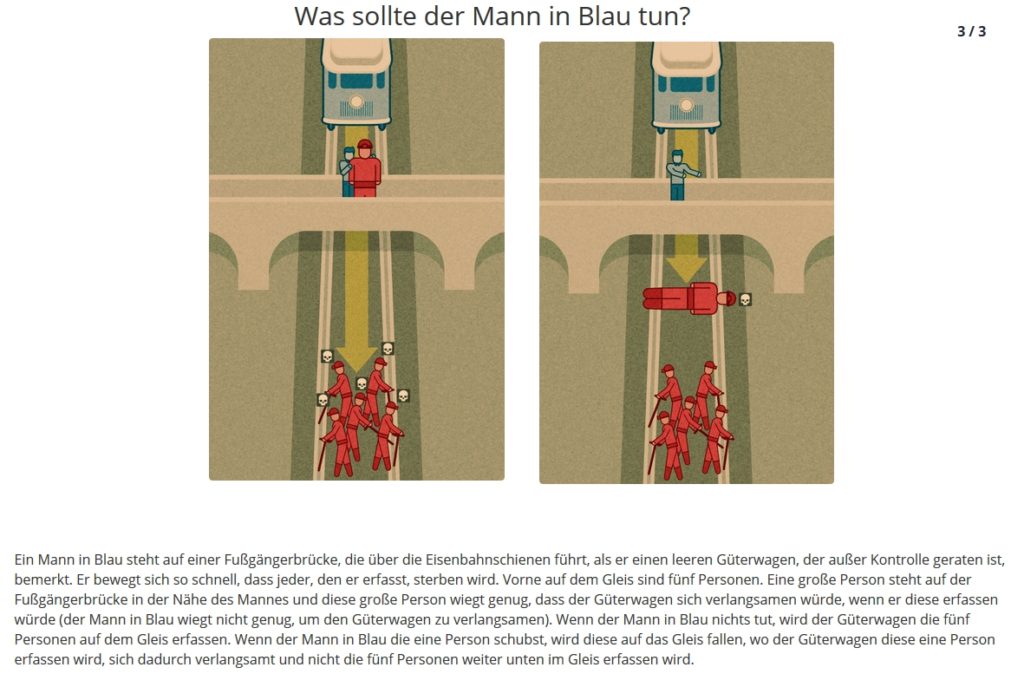

Hier schon mal ein Einstieg in die Problematik: Der Klassiker mit dem „Mann in Blau“.

Bürgersicht Die alternative, unkonventionelle Sichtweise

Bürgersicht Die alternative, unkonventionelle Sichtweise